Yuval Noah Harari ha lanzado nuevamente una advertencia sobre los riesgos de la Inteligencia Artificial (IA). En una reciente conferencia dijo que la “IA representa el fin de la historia humana, el fin del periodo dominado por los seres humanos”.

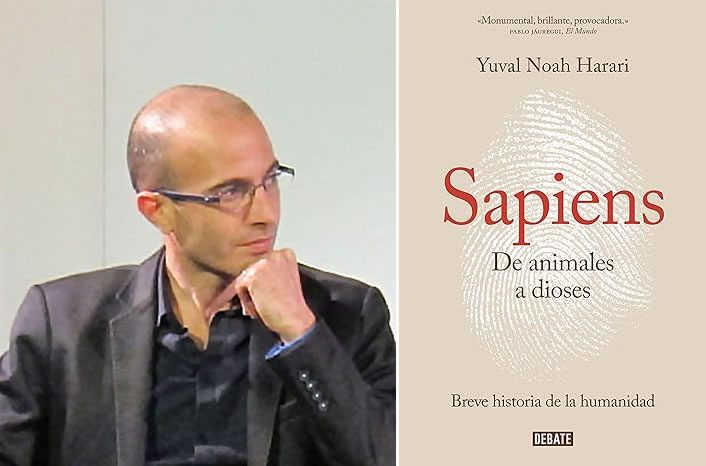

Se están invirtiendo miles de millones de dólares en el desarrollo de la IA, una tecnología que se considera una “revolución”, pero que el famoso historiador y filósofo Yuval Noah Harari la considera como una “especie alienígena” que podría provocar la extinción de la humanidad.

Inteligencia artificial representa el fin de la historia humana

Harari dijo en el CogX Festival de Londres:

“La inteligencia artificial es fundamentalmente diferente de todo lo que hemos visto en la historia, de cualquier otro invento, ya sean las armas nucleares o la imprenta.

Es la primera herramienta de la historia que puede tomar decisiones por sí misma. Las bombas atómicas no podían tomar decisiones. La decisión de bombardear Hiroshima la tomó un humano”.

El riesgo que conlleva esta capacidad de pensar por sí misma, según Harari, es que las máquinas superinteligentes acaben usurpando a la raza humana como potencia dominante del mundo.

Potencialmente estamos hablando del fin de la historia humana, del fin del periodo dominado por los seres humanos.

Es muy probable que en los próximos años se coma toda la cultura humana, [todo lo que hemos conseguido] desde la Edad de Piedra, y empiece a vomitar una nueva cultura procedente de una inteligencia alienígena”.

“Inteligencia artificial puede ser más creativa que las personas”

Según Harari, el uso de la IA genera interrogantes sobre lo que la tecnología hará no sólo al mundo físico que nos rodea, sino también a cosas como la psicología y la religión.

Harari argumentó:

“En ciertos aspectos, la IA puede ser más creativa [que las personas]. Al final, nuestra creatividad está limitada por la biología orgánica. Esto es una inteligencia no orgánica. Es realmente como una inteligencia alienígena.

Si dijera que dentro de cinco años llegará una especie alienígena, que tal vez sea simpática, que tal vez cure el cáncer, pero que nos arrebatará el poder de controlar el mundo, la gente se aterrorizaría.

Esta es la situación en la que estamos, pero en lugar de venir del espacio exterior, [la amenaza viene] de California”.

Evolución de la inteligencia artificial

El fenomenal auge del chatbot de IA generativa de OpenAI, ChatGPT, en el último año ha sido un catalizador de grandes inversiones en el espacio, con las grandes tecnológicas entrando en una carrera por desarrollar los sistemas de inteligencia artificial más punteros del mundo.

Pero es el ritmo de desarrollo en el espacio de la IA, según Harari -cuyas obras escritas han examinado el pasado y el futuro de la humanidad- lo que “lo hace tan aterrador”.

Harari dijo a los asistentes al Festival CogX:

“Si lo comparamos con la evolución orgánica, la IA es ahora como [una ameba]: en la evolución orgánica, tardaron cientos de miles de años en convertirse en dinosaurios.

Con la IA, la ameba podría convertirse en un T. rex en 10 o 20 años. Parte del problema es que no tenemos tiempo para adaptarnos. Los humanos somos seres asombrosamente adaptables… pero lleva tiempo, y no lo tenemos”.

¿El próximo “enorme y terrible experimento” de la humanidad?

Admitiendo que innovaciones tecnológicas anteriores, como la máquina de vapor y los aviones, habían suscitado advertencias similares sobre la seguridad humana y que “al final no pasó nada”, Harari insistió en que cuando se trata de la IA, “al final no es lo suficientemente buena”.

Harari dijo:

“No somos buenos con las nuevas tecnologías, tendemos a cometer grandes errores, experimentamos.

Durante la Revolución Industrial, por ejemplo, la humanidad había cometido ‘algunos errores terribles’, mientras que el imperialismo europeo, el comunismo del siglo XX y el nazismo también habían sido ‘enormes y terribles experimentos que costaron la vida a miles de millones de personas’.

Hemos necesitado un siglo, siglo y medio, de todos estos experimentos fallidos para acertar de alguna manera.

Puede que esta vez no sobrevivamos. Incluso si lo hacemos, piensa en cuántos cientos de millones de vidas se destruirán en el proceso.”

Tecnología divisiva

A medida que la IA se hace cada vez más omnipresente, los expertos se muestran divididos sobre si esta tecnología supondrá un renacimiento o el día del juicio final.

En la Yale CEO Summit, celebrada este verano por invitación, casi la mitad de los directores ejecutivos encuestados afirmaron creer que la IA podría destruir la humanidad en los próximos cinco a diez años.

En marzo, 1.100 destacados tecnólogos e investigadores de IA -entre ellos Elon Musk y Steve Wozniak, cofundador de Apple- firmaron una carta abierta en la que pedían una pausa de seis meses en el desarrollo de potentes sistemas de IA. Señalan la posibilidad de que estos sistemas estén ya en vías de alcanzar una superinteligencia que podría amenazar a la civilización humana.

Musk, cofundador de Tesla y SpaceX, ha dicho por separado que la tecnología golpeará a la gente “como un asteroide” y ha advertido de que existe la posibilidad de que “se convierta en Terminator“. Musk ha lanzado su propia empresa de inteligencia artificial, xAI, con la que pretende “comprender el universo” y evitar la extinción de la humanidad.

Sin embargo, no todo el mundo comparte la opinión de Musk de que las máquinas superinteligentes podrían acabar con la humanidad.

El mes pasado, más de 1.300 expertos se reunieron para calmar los temores de que la IA cree una horda de “evil robot overlords” (malvados robots), mientras que uno de los tres llamados Padrinos de la Inteligencia Artificial ha calificado de “ridículamente absurda” la preocupación de que esta tecnología se convierta en una amenaza existencial.

Nick Clegg, alto ejecutivo de Meta, también trató de calmar las inquietudes sobre esta tecnología en una entrevista reciente, insistiendo en que los grandes modelos lingüísticos en su forma actual son “bastante estúpidos” y, desde luego, no lo bastante inteligentes como para salvar o destruir la civilización.

Yuval Noah Harari es el autor del best seller “Sapiens”. Puede conseguirlo en Amazon.

El tiempo es oro

A pesar de sus propias advertencias funestas sobre la IA, Harari afirmó que aún se está a tiempo de hacer algo para evitar que las peores predicciones se hagan realidad.

Harari dijo:

“Nos quedan unos cuantos años, no sé cuántos -cinco, diez, treinta-, en los que todavía podemos conducir antes de que la IA nos empuje al asiento de atrás. Deberíamos utilizar estos años con mucho cuidado”.

Sugirió tres medidas prácticas que podrían adoptarse para mitigar los riesgos en torno a la IA: no dar libertad de expresión a los bots, no dejar que la inteligencia artificial se haga pasar por humana y gravar las grandes inversiones en IA para financiar la regulación y las instituciones que puedan mantener la tecnología bajo control.

Harari dijo:

“Hay mucha gente tratando de impulsar estas y otras iniciativas. Espero que las pongamos en marcha lo antes posible, porque el tiempo apremia”.

También instó a quienes trabajan en el ámbito de la IA a plantearse si liberar sus innovaciones en el mundo redunda realmente en beneficio del planeta.

Harari agregó:

“No podemos detener el desarrollo de la tecnología, pero debemos distinguir entre desarrollo e implantación. Que la desarrolles no significa que tengas que desplegarla”.

Yuval Harari también tuvo una interesante conversación con Mustafa Suleyman (CEO de Inflection AI) y Zanny Minton Beddoes en la que discutieron: ¿Cómo afectará la IA a nuestro futuro inmediato y cercano? ¿Se puede controlar la tecnología?

Pueden verlo a continuación:

Aunque el audio del siguiente vídeo se encuentra en inglés, usted puede activar los subtítulos en español. En caso desconozca cómo hacerlo, puede consultar esta GUÍA.

[H/T: fortune.com]

¿Te gustó este contenido? Te invito a compartirlo con tus amigos. También puedes seguirnos en nuestra Fan Page, para estar al tanto de todas las noticias que publicamos a diario. También puedes unirte a nuestro Grupo Oficial y a nuestra comunidad en Telegram.

Crédito imagen de portada: depositphotos.com

0 comentarios